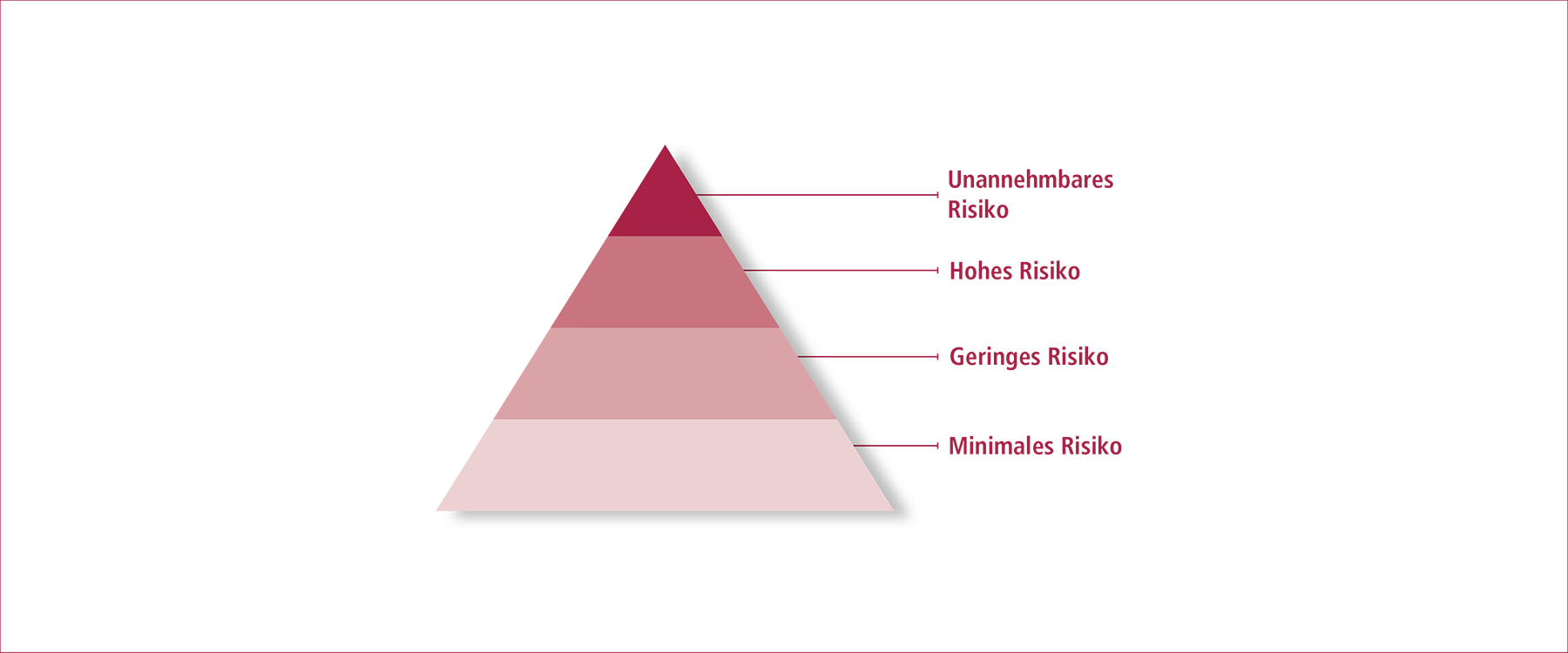

Im Zentrum des AI Acts steht die Risiko- oder Kritikalitätsbewertung von KI-Systemen. Der AI Act bestimmt Regeln für KI-Systeme entsprechend ihrem Gefahrenpotenzial. Dazu werden KI-Anwendungen in vier Risikostufen klassifiziert – vom minimalen Risiko bis hin zum unannehmbaren Risiko.

Was regelt der AI Act der EU?

Die Europäische Union (EU) hat ein gemeinsames Regelwerk verabschiedet, das zu einer vertrauenswürdigen Gestaltung und Nutzung von Künstlicher Intelligenz beitragen soll: den Artificial Intelligence (AI) Act. In Kraft getreten ist dieser am 01. August 2024 und ist damit das weltweit erste Gesetz zur Regulierung von KI.

Verbindliche Regeln für den KI-Einsatz in Europa

Ziel des AI Acts der EU ist es, den Einsatz von KI-Systemen sicher und vertrauenswürdig zu machen, ohne Innovationen zu hemmen. Ein ausdifferenziertes Regelwerk macht verpflichtende Vorgaben für die Entwicklung und Anwendung von risikoreichen KI-Systemen. So werden technische wie auch ethische Standards vorgeschrieben, um die Grundrechte der EU-Bürgerinnen und -Bürger zu schützen und zugleich den Wirtschaftsstandort Europa global zu stärken.

Diese Regeln gelten als der erste transnationale Versuch, KI mit verbindlichen und gemeinsam ausgehandelten Normen zu gestalten. Was bereits in vielen anderen Bereichen existiert, beispielsweise in der Medizintechnik oder der Regulierung von Impfstoffen, wird nun auch für die KI geschaffen: verbindliche Regeln für eine vertrauenswürdige Technik. Damit nimmt die EU eine Vorreiterrolle zugunsten der europäischen Gesellschaft und Wirtschaft ein. Durch die rechtlichen Rahmenbedingungen für KI schafft die EU nicht nur Transparenz für Nutzerinnen und Nutzer und Rechtssicherheit für Unternehmen, sondern sichert auch die technologische Souveränität des Kontinents. Im internationalen Wettbewerb können sich europäische Wertvorstellungen als Qualitätsmerkmal einer vertrauenswürdigen KI durchsetzen – Stichwort: „KI made in Europe“.

Was ist KI im Sinne des AI Acts?

Die EU-Verordnung definiert Künstliche Intelligenz in Anlehnung an die Empfehlungen der OECD. Demnach ist eine KI „ein maschinenbasiertes System, das für explizite oder implizite Ziele aus Eingaben Ergebnisse wie Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen generiert, die Auswirkungen auf physische oder virtuelle Umgebungen haben können.“

Wie regelt der AI Act den Einsatz von KI?

Für Hochrisiko-KI-Systeme, deren Risiken als unannehmbar eingestuft werden, gilt ein pauschales Verbot. Darunter fällt die behördliche Bewertung des sozialen Verhaltens anhand öffentlich verfügbarer Daten aus dem Internet (Social Scoring), biometrische Kategorisierung, die auf sensible Daten wie die sexuelle Orientierung oder religiöse Überzeugungen schließen lässt, KI-Systeme, die menschliches Verhalten manipulieren und solche, die die Schwachstellen von Schutzbedürftigen ausnutzen, Emotionserkennung am Arbeitsplatz oder in Bildungseinrichtungen, massenhaftes, ungezieltes Auslesen von Gesichtsbildern aus dem Internet (Scraping) und teils präventive Polizeiarbeit, bei der mithilfe von KI die Wahrscheinlichkeit einer Straftat berechnet wird (Predictive Policing).

Wenn von KI-Systemen erhebliche Risiken für die Gesundheit und die Grundrechte von Personen, für Rechtsgüter oder die Umwelt ausgehen, müssen sie bestimmte Anforderungen erfüllen, um Zugang zum EU-Markt zu erhalten. Darunter fallen zum Beispiel KI-Systeme, die auf das Wahlverhalten Einfluss nehmen, die nachträgliche Auswertung von im öffentlichen Raum erfassten biometrischen Daten und viele KI-Systeme in der Medizin oder für die Justiz.

Laut KI-Verordnung müssen Hersteller und Anwender von potenziellen Hochrisiko-Systemen deren Folgen auf Umwelt und Grundrechte abschätzen, bevor das System zum Einsatz kommen kann. Hochrisiko-Systeme müssen dann einer Konformitätsbewertung unterzogen werde, bei der geprüft wird, ob die Systeme den EU-Anforderungen entsprechen. Alle Hersteller von Hochrisiko-Systemen und öffentliche Behörden, die die Systeme nutzen, müssen sich in einer EU-Datenbank registrieren.

Ziel ist es, dass die Nutzer einen Überblick über die Funktionsweise des Systems erhalten. Die Entscheidung über die weitere Nutzung der Anwendung obliegt damit den Bürgerinnen und Bürgern. Ein Beispiel hierfür sind automatisierte Film- oder Musikempfehlungen.

Systeme, die nur ein minimales oder kein Risiko für die Grundrechte darstellen, unterliegen keinen Vorschriften. Diese Kategorie umfasst die meisten KI-Systeme, wie KI-gestützte Videospiele. Anbieter solcher Systeme können sich freiwillig Verhaltenskodizes unterwerfen. So können auch Produkte mit minimalem Risiko einige oder alle Anforderungen des AI Acts erfüllen.

Spezielle Regeln gelten für:

Basismodelle oder Foundation Models sind Modelle des maschinellen Lernens, die mit extrem großen Datensätzen z. B. aus dem Internet vortrainiert wurden und verschiedene Aufgaben ausführen können. Zu ihnen zählen u.a. die generativen KI-Sprachmodelle GPT-4 (OpenAI), Gemini (Google) oder Llama (Meta). Anbieter von Basismodellen müssen für Transparenz sorgen, indem sie technische Dokumentationen zu den angewendeten Trainings- und Testverfahren sowie zu den Trainingsdaten erstellen und nachweisen, dass sie das europäische Urheberrecht einhalten. Dabei wird nach Rechenkapazität unterschieden: Sehr leistungsstarke Basismodelle unterliegen strengeren Regeln, denn von ihnen können systemische Risiken ausgehen, die sich je nach späterem Anwendungszweck weiterverbreiten. Die zusätzlichen Pflichten betreffen etwa Cybersicherheit und Energieeffizienz.

Die biometrische Überwachung von Personen in Echtzeit ist weitestgehend verboten. Eine Ausnahmeregelung gilt für die Strafverfolgung: Liegt eine konkrete Gefährdung wie ein Terroranschlag vor oder eine schwere Straftat aus einer definierten Liste, dürfen die Behörden bei richterlicher Genehmigung einzelne Personen im öffentlichen Raum biometrisch identifizieren. Die nachträgliche Auswertung biometrischer im öffentlichen Raum erfasster Daten wird als Hochrisiko-Anwendung eingeordnet, ist aber grundsätzlich zulässig. Strafverfolgungsbehörden können auf diese Weise unter Einhaltung strenger Schutzvorkehrungen Straftäter ausfindig machen.

Der AI Act gilt nicht für KI-Systeme, die für Forschung und Entwicklung eingesetzt werden oder Systeme, die ausschließlich militärischen oder verteidigungspolitischen Zwecken dienen. Er berührt überdies auch nicht die Zuständigkeiten der Mitgliedstaaten in Bezug auf die nationale Sicherheit.

Wie wird der AI Act umgesetzt?

Der AI Act hat einen rechtlich bindenden Charakter – und in allen EU-Mitgliedsstaaten dieselbe Gültigkeit wie ein nationales Gesetz. Eine erneute Zustimmung der jeweiligen nationalen Parlamente ist nicht notwendig. Der AI Act ist am 01. August 2024 in Kraft getreten. Verbote und Verpflichtungen sind nun schrittweise einzuhalten:

02. Februar 2025

KI-Systeme mit unannehmbarem Risiko sind verboten; Unternehmen müssen Beschäftigte im Umgang mit KI schulen

02. August 2025

Governance-Regeln und Verpflichtungen für KI-Modelle für allgemeine Zwecke (General-Purpose AI) werden wirksam

02. August 2026

Großteil der Regelungen wird wirksam, etwa für Hochrisiko-KI-Systeme

02. August 2027

Regeln für KI-Systeme (eingebettet in regulierte Produkte) greifen

European AI Office: Vernetzung und Governance

Eine Schlüsselrolle bei der Umsetzung des AI Acts spielt das im Februar 2024 gegründete European AI Office. Es bündelt das KI-Fachwissen und unterstützt die Leitungsgremien in den Mitgliedsstaaten bei der kohärenten Anwendung der EU-Verordnung. Zudem fördert es Austausch und Kooperation unter den Stakeholdern im KI-Sektor. Das European AI Office bildet die Grundlage für ein einheitliches europäisches KI-Governance-System und überwacht die Einhaltung und Implementierung der Regeln.

Das European AI Office steuert auch den Konsultationsprozess zur Konkretisierung der Vorgaben für die Anbieter von KI-Modellen für allgemeine Zwecke (General-Purpose AI, GPAI). Da diese für eine Vielzahl von Aufgaben eingesetzt werden können und somit die Grundlage für nachgelagerte KI-Systeme bilden, soll sichergestellt werden, dass sie sicher und vertrauenswürdig sind. Der AI Act sieht daher einen Verhaltenskodex (Code of Practice) für KI-Modelle für allgemeine Zwecke vor, der kritische Bereiche wie Transparenz, urheberrechtliche Vorschriften und Risikomanagement behandelt. Die iterative Ausarbeitung dieses Verhaltenskodex startete im September 2024 unter Einbeziehung von rund 1.000 interessierten VertreterInnen aus Unternehmen, Wissenschaft und Zivilgesellschaft und soll bis April 2025 abgeschlossen sein. Mehr zu den Anforderungen von General-Purpose AI Models im AI Act.

Stimmen aus der Plattform Lernende Systeme zur Ausarbeitung des Verhaltenskodex:

Freiwillig voran im KI-Pakt

Um den Übergang zum neuen Rechtsrahmen zu erleichtern, hat die Europäische Kommission den KI-Pakt ins Leben gerufen. Mit der Initiative ermutigt sie die Industrie, die Vorschriften des AI Acts freiwillig früher als gesetzlich vorgeschrieben umzusetzen. In Workshops, die das AI Office organisiert, sollen sich die teilnehmenden Akteure austauschen, ein gemeinsames Verständnis schaffen sowie konkrete Maßnahmen anregen. Zudem werden sie ermutigt, Prozesse und Praktiken proaktiv offenzulegen und Compliance zu antizipieren. Dies gilt vor allem für Unternehmen, die KI-Systeme bereitstellen.

Zu den Erstunterzeichnern des KI-Pakts zählen mehr als 100 Unternehmen, darunter sowohl multinationale Konzerne als auch kleine und mittlere Unternehmen verschiedener Branchen. Sie verpflichten sich mindestens zu folgenden Maßnahmen:

- Entwicklung einer KI-Governance-Strategie, um die Einführung von KI in der Organisation zu fördern und auf die künftige Einhaltung des KI-Gesetzes hinzuarbeiten.

- Kartierung von KI-Systemen mit hohem Risiko: Identifizierung von KI-Systemen, die nach dem KI-Gesetz wahrscheinlich als risikoreich eingestuft werden.

- Förderung der KI-Kenntnisse und des Bewusstseins der Beschäftigten, um eine ethische und verantwortungsvolle KI-Entwicklung zu gewährleisten.

Gezielte Förderung für KI-Start-Ups und KMU

Um innovative europäische Start-ups und kleine und mittlere Unternehmen bei der Entwicklung von vertrauenswürdiger KI zu unterstützen, kündigte die Europäische Kommission im Januar 2024 an, ihnen für das Trainieren ihrer KI-Modelle Zugang zu Supercomputern zu ermöglichen. Die Initiative GenAI4EU und das European AI Office werden gemeinsam zur Entwicklung neuer Anwendungsfälle Bereichen wie Robotik, Gesundheit, Biotechnologie, Fertigung, Mobilität oder Klimaschutz beitragen.

Normen für KI

Damit der AI Act als rechtliche EU-Verordnung umgesetzt werden kann, arbeitet die EU aktuell an Normen, die die Inhalte für die Anwendung in der Praxis konkretisieren. So sollen rechtliche Gestaltung und technische Implementierung im besten Fall reibungslos synchronisiert werden. Um solche Normen zu erarbeiten, hat die Europäische Kommission das Europäische Komitee für Normung CEN sowie das Europäische Komitee für elektrotechnische Normung CENELEC beauftragt.

Sanktionen

Für Verstöße gegen die KI-Verordnung werden Geldbußen erhoben – entweder als Prozentsatz des weltweiten Jahresumsatzes des Unternehmens oder als festgelegter Betrag, je nachdem, welche Summe höher ist. Für kleine und mittlere Unternehmen sowie für Start-ups gibt es eine verhältnismäßige Obergrenze.

Publikationen zum Thema